1. Projet mené par Brigitte Plomteux et portant sur la compétence « compréhension à la lecture » relative à un texte d’un sujet à caractère socio-économique et visant une compréhension fine de l’entièreté du texte

Tout d’abord, il s’agit d’établir un état des lieux de la situation actuelle (année 2020 – 2021) afin de connaitre la situation de départ et de pouvoir mesurer l’impact éventuel et espéré des (tentatives de) solutions mises en place. Cela implique de faire une observation fine des réponses fournies par les étudiants au test « compréhension à la lecture » de l’examen:

• quelle réponse ont-ils donnée pour chaque item?

• quel pourcentage de réponses correctes pour chaque item demandé?

• pour quels items les réponses sont-elles les meilleures/les moins bonnes? Qu’est-ce qui pourrait expliquer ces bonnes ou moins bonnes réponses?

• qu’est-ce qui peut expliquer les erreurs commises? Manque de temps, manque de vocabulaire (qui incite à répondre au petit bonheur la chance), erreurs de compréhension de la phrase, erreurs d’analyse grammaticale (nature et fonction)

Pour obtenir cette analyse aussi fine que possible, deux actions sont en cours:

• une copie a été faite des réponses fournies par les étudiants (« copier-coller » du test réalisé sur HELMo Learn), qui permettra d’avoir pour chaque item la réponse aux questions ci-dessus (analyse quantitative principalement)

• les étudiants ont, après leur examen de janvier 2019, fait en classe une traduction du texte de l’examen (cette fois sans mots manquants, ils disposaient donc, à l’inverse, de ce qui était le cas à l’examen, du texte complet) . Analyser ces traductions permet de :

- vérifier la compréhension globale du texte

- faire un parallèle avec les réponses fournies dans l’exercice « gap fill »

• Et une troisième récolte d’informations (plus sporadique, mais illustrant bien certains problèmes constatés) porte sur des exemples, tirés de productions écrites des étudiants, d’erreurs portant sur la méconnaissance des règles d’orthographe et de formation des mots en néerlandais. Les préfixes on- (notion négative, correspondant au français in- , im- , il-) et ont- (indiquant le début de l’action, ou le fait d’ôter quelque chose) sont souvent confondus. Sont-ce des indicateurs de mauvaise compréhension, faut-il ou non y remédier (dans le sens « est-ce que le jeu en vaut la chandelle »)? et si oui, comment?

A l’heure actuelle, l’état de l’analyse est le suivant:

• Encodage dans un classeur Excel des réponses fournies au test gap fill en ligne. Cet encodage permet d’avoir une vue d’ensemble des réponses fournies et de pouvoir traiter les données ainsi récoltées.

Pour chaque réponse, un code est attribué:

1: la réponse est correcte (l’étudiant a choisi le mot qui convient dans la liste proposée)

2: la réponse est plausible (la phrase fait sens avec le mot choisi, mais n’est pas le mot du texte original) et grammaticalement correcte (le mot a la bonne nature – un substantif en remplace un autre – et / ou est placé à un endroit logique – participe passé en fin de proposition)

3: la réponse fait sens (le mot correspond au contexte) mais n’est grammaticalement pas correcte (insérer le mot choisi par l’étudiant à cet endroit crée une phrase incorrecte)

4: la réponse est totalement incorrecte (le mot ne fait pas sens, et la grammaire n’est pas correcte non plus)

Reste encore deux questions concernant le classement de ces réponses:

- quid des items laissés blancs?

- quid des mots utilisés deux fois?

Avec ces codes, voici les actions possibles: - affiner la cote que l’étudiant a obtenue à l’examen, où la nuance en quatre étapes développée ci-dessus n’était pas possible. Constate-t-on une différence, et si oui, celle-ci est-elle significative?

- dans la dernière phase du projet, voir si les étudiants ont pu améliorer leur score, surtout en choisissant des mots de nature correcte dans la phrase qu’ils doivent compléter.

• Encodage dans un (autre) classeur Excel des traductions fournies par les étudiants. Cet encodage, fastidieux et nécessaire, donne par exemple les éclairages suivants, qui doivent être affinés:

- les phrases françaises produites par les étudiants sont loin d’être bien construites (chiffres à affiner)

- ces phrases n’ont pas toutes du sens (exemple: “s’occuper d’une histoire vraie, romp – mot non compris par l’étudiante, et laissé tel quel) et commence”).

- les traductions montrent une méconnaissance de la nature des mots, source d’erreurs. Exemple avec “onderbouwd”, participe passé du verbe “onderbouwen”, qui signifie “étayer”. Il est composé de deux élements connus des étudiants: la particule “onder” et le verbe ”bouwen”. Si on retrouve ces éléments dans la traduction, l’ensemble ne fait pas sens (“bien étayé par des arguments” devient ”une bonne construction des arguments”, “un bon fond avec des arguments”, …)

- les étudiants ne semblent pas être suffisamment conditionnés à tenir compte des éléments de fin de proposition, particulièrement importants en néerlandais, et passent donc à côté du sens de la phrase

- un manque de connaissance des éléments constitutifs des mots (préfixes, suffixes, racines). Or comme le dit Dehaene (2007) “Le lecteur expert est, avant tout, un fin lettré qui connait quantité de préfixes, de racines ou de suffixes et les associe sans effort à leur prononciation et à leur sens.”

- pour certains mots en principe courants (faisant partie du vocabulaire de base censé connu) mais utilisés dans le texte avec un autre sens / une autre nature, l’étudiant est victime du biais heuristique (Houdé 2014) et n’utilise pas les autres informations dont il dispose (contexte, grammaire, logique) pour aller au-delà de l’évidence et questionner son raisonnement. On peut y voir l’importance de la création des connexions synaptiques adéquates, avec un travail à réaliser en amont sur ce que ça signifie de connaitre un mot (voir les références sur les ouvrages traitant du vocabulaire et du lexique).

Il y a cependant quelques « caveats » à prendre en compte dans l’exécution de cette analyse et, partant, dans l’interprétation des résultats obtenus:

• le test sur HELMo Learn a été fait en situation d’examen (stress, contrainte de temps, réponses au hasard en espérant gagner un point …), la traduction a été faite lors du premier cours du second quadrimestre (étudiants absents, deuxième contact avec le texte après le contact de l’examen, mise en place pratique – il manque par exemple quelques noms sur les traductions, il est donc impossible de comparer parfaitement ces traductions aux réponses fournies dans l’exercice « gap fill ») ;

• pour ce qui est de la traduction, les étudiants ne sont pas habitués à ce type d’exercice qui leur a d’ailleurs pris beaucoup de temps – quelle est dès lors la valeur de leur traduction?

• si l’on peut comparer facilement les réponses fournies dans le test « gap fill », ce sera moins facile pour la traduction, exercice beaucoup plus libre ;

• on ne connait pas, ou on ne peut connaitre que très approximativement, le niveau de néerlandais des étudiants concernés, ce qui ne permet pas une vision complète de la performance.

Une fois ces informations, aussi imparfaites et imprécises soient-elles, collectées et analysées, on pourra envisager des actions afin d’améliorer la compétence « lecture » chez les étudiants.

Pour cela, plusieurs éléments théoriques, certains déjà évoqués ci-dessus, devront être pris en compte.

Tout d’abord, et vu leur omniprésence actuelle liée à leur évolution ultrarapide et aux découvertes nombreuses qu’on leur doit, les neurosciences devront avoir une place de choix dans la réflexion proposée. Grâce à de nombreuses recherches, à l’amélioration des connaissances sur le cerveau et son fonctionnement, on sait maintenant comment le cerveau lit – en tout cas en langue maternelle. Ces connaissances doivent avoir un impact sur la manière dont on enseigne la lecture – importance notamment de la connaissance des préfixes, suffixes et racines de mots. Une recherche documentaire s’impose sur l’impact de ces connaissances sur les performances en lecture.

Ensuite, il faudra se pencher sur les aspects positifs et négatifs de l’exercice « gap fill » comme mesure de la compétence en compréhension à la lecture. L’exercice présente de nombreux avantages pratiques: facilité de mise en place, correction purement objective, ne faisant pas intervenir des aspects connexes comme le style employé dans une traduction par exemple. Mais est-ce un bon, voire le meilleur moyen de tester la compréhension à la lecture?

Se pose aussi la question des stratégies, souvent utilisées dans l’enseignement des langues étrangères pour pallier un manque de connaissances (en vocabulaire notamment): sont-elles un moteur de compréhension ou un frein à celle-ci? Quelles stratégies sont mises en place par les étudiants pour comprendre un texte, avec quels effets?

Avec tous ces éléments, il faudra pouvoir proposer aux étudiants des outils améliorant leur compréhension à la lecture – non pas pour qu’ils obtiennent de meilleurs résultats à l’examen, mais bien pour qu’ils deviennent de meilleurs lecteurs.

Ces outils, s’ils s’avèrent efficaces (mesure à faire en comparant les résultats de différentes cohortes au test de compréhension à la lecture) pourraient et / ou devraient être généralisés à l’ensemble des étudiants du département économique, voire au-delà.

2. Projet mené par Sabine Jacob et portant sur Développement d’un outil d’entrainement en ligne pour améliorer et consolider la maîtrise des règles écrites du français

Etant donné que ce projet repose sur une série de collaborations, le « nous » nous a semblé plus approprié que le « je ». Les différents échanges (réunions, séances de travail…) illustrant ces collaborations sont listés dans l’onglet « Divers« .

Notre premier souhait était de ne pas recourir à une plateforme payante. En effet, nous souhaitions que les étudiants jouissent d’un outil accessible et gratuit. Par ailleurs, nous voulions que celui-ci cible les notions élémentaires les plus problématiques de l’orthographe, laissant ainsi de côté les subtilités de la langue pour privilégier son usage quotidien et les difficultés que les étudiants sont susceptibles de rencontrer (courriels professionnels, lettres de motivation, comptes rendus, thèses, rapports de stage, etc.).

- Analyse des besoins et état des lieux

Ensuite, afin de ne pas créer un outil redondant, c’est-à-dire qui soit une réplique d’un outil déjà existant, nous avons commencé par établir une liste non exhaustive des outils de remédiation en orthographe, tout en relevant leurs atouts et leurs limites. Cet « inventaire » a nourri notre réflexion au moment de concevoir notre Parcours guidé en maîtrise du français.

- Conception et réalisation du Parcours guidé

Architecture

Le parcours s’articule autour de 5 compétences et comporte deux tests récapitulatifs, l’un à mi-chemin et l’autre en fin de parcours. Ces cinq compétences sont détaillées ci-après.

Il comporte 12 tests, répartis dans les différentes compétences, à faire dans un laps de temps de 12 semaines, ce qui amène donc l’étudiant à faire un test par semaine. Pour passer d’un test à l’autre, l’étudiant doit obtenir la note de 16/20. Chaque test est composé de 20 items choisis par Moodle de façon aléatoire. Ce qui veut dire que l’étudiant qui n’a pas obtenu la note de passage requise recommencera le test avec d’autres questions. Il aura également accès à des ressources. L’avantage de ce système est que les étudiants initialement « bons » en orthographe valident rapidement une compétence et peuvent passer à la suivante. Ainsi le temps passé sur la plateforme ne se substitue pas à celui passé à travailler d’autres matières. A l’inverse, les étudiants ne maîtrisant pas les prérequis en maîtrise de la langue devront passer davantage de temps à s’exercer pour progresser dans le parcours.

– La compétence grammaticale

« Pour appliquer une règle d’accord et mettre une marque de genre et de nombre au bon endroit, il ne suffit pas de pouvoir réciter la règle, il faut aussi savoir catégoriser les mots et identifier les relations qui les unissent. Pour accorder un adjectif, il faut d’abord le reconnaitre comme adjectif et trouver avec quoi il s’accorde ; […]. » (Brissaud et al., 2013)

L’objectif de ce premier module est donc de permettre aux étudiants de travailler l’analyse grammaticale et de développer ainsi leur conscience métalinguistique, c’est-à-dire la conscience et l’analyse qu’on peut porter sur le langage.

La terminologie utilisée se veut la plus simple possible, afin d’être aisément appropriable. Nous avons donc volontairement laissé de côté les terminologies complexes, sources d’incompréhension et de découragement.

– La compétence orthographique

Alors que les autres compétences comportent un seul test, la compétence orthographique se compose de 6 tests : 1 test sur les homophones grammaticaux, 1 test sur la conjugaison, 1 test sur l’accord sujet-verbe, 2 tests sur l’accord des participes passés (niveau 1 et niveau 2) et 1 test sur l’accord du déterminant, de l’adjectif et du nom

– La compétence syntaxique

Etant donné que c’est la syntaxe qui régit les règles de ponctuation, nous avons regroupé ces deux aspects dans la même compétence.

Au niveau de la syntaxe, les items portent sur des phénomènes linguistiques relevant aussi bien de la phrase (prépositions, pronoms relatifs, etc.) que du texte (pronoms anaphoriques et autres).

En ce qui concerne la ponctuation[1], nous avons essentiellement tenu compte des signes pausaux qui séparent les éléments de texte et permettent des pauses plus ou moins longues (ex. : le point, la virgule, le point-virgule) et des signes mélodiques qui sont au service de la fonction expressive (ex. : le point d’exclamation, d’interrogation, les points de suspension, etc.).

– La compétence typographique

Dans ce module sont travaillés les accents, les majuscules et les traits d’union.

– La compétence lexicale

Au départ, nous ne souhaitions pas intégrer cette compétence, car la plupart des ordinateurs sont équipés de correcteurs orthographiques relativement performants. Cependant, à force de rencontrer, dans les copies des étudiants, des termes mal orthographiés comme « chiffre d’affaire » ou « travail de fin d’étude », nous avons décidé de concevoir un module reprenant des erreurs lexicales récurrentes.

– Deux tests récapitulatifs

Un test récapitulatif, reprenant l’ensemble des règles vues à ce stade, clôt la compétence orthographique et un test final termine le parcours, permettant à l’utilisateur de revoir l’ensemble des difficultés abordées.

Lexique

En ce qui concerne le vocabulaire des items, nous avons choisi soit des termes issus de la vie de tous les jours, soit des termes relevant du domaine économique (ancrage professionnalisant).

Banque de questions

La banque de questions est la partie dont la réalisation est la plus chronophage. Heureusement, nous disposions déjà d’une banque de questions créée pour un autre espace de « Remédiation en langue française » à laquelle nous avons ajouté d’autres questions, parfois des nouvelles fraichement créées ou des questions déjà existantes dans les espaces d’autres professeurs. Le problème réside dans le fait que lorsqu’on mutualise des ressources de la sorte, il est impératif d’uniformiser un certain nombre d’éléments comme notamment le titre de la question, la formulation de la consigne, ou la forme du feedback. Ces difficultés nous ont amenés à concevoir un cahier des charges pour les concepteurs de questions.

Pour ce qui est des types de questions, voici ceux que nous avons choisi d’utiliser : vrai/faux, choix multiple, mot(s) à insérer (cloze), glisser-déposer sur texte et sélection de mot(s).

Le choix du type de question dépend de la compétence testée. En effet, pour certaines compétences comme la syntaxe et la ponctuation, il est difficile de recourir à un autre type que le choix multiple ou le vrai ou faux. Par contre, pour la compétence orthographique, par exemple, il nous a semblé opportun de ne pas nous limiter à tester la capacité de l’étudiant à choisir la bonne forme dans une liste fournie, mais de tester également sa capacité à recourir à ses propres stratégies d’analyse pour fournir la forme du mot souhaitée dans un contexte phrastique ou encore de tester sa capacité à reconnaitre des mots mal orthographiés dans un contexte phrastique.

Pour certains items, nous avons combiné deux types de questions, de façon à attirer l’attention de l’étudiant sur la règle, sur la démarche. Ainsi, dans ces items, il faut d’abord choisir la règle correcte parmi celles proposées, puis écrire la réponse demandée. Plus concrètement, cela signifie que dans une question d’accord des participes passés avec avoir, par exemple, l’étudiant doit choisir dans un menu déroulant si le COD est placé avant ou après ou s’il n’y en a pas. Après cette étape, il doit orthographier correctement le participe passé.

Ressources

Dans les différents modules du Parcours, les utilisateurs ont accès à différents types de ressources.

L’une d’elles est le glossaire. Il s’agit de notions accompagnées de leur définition, à la manière d’un dictionnaire. Ces notions sont classées dans des catégories. L’utilisateur peut effectuer des recherches de termes dans le glossaire. Cependant, les termes qui se trouvent à la fois dans le glossaire et ailleurs dans le cours sont accessibles via la fonction de lien automatique. En d’autres termes, des notions grammaticales ou encore des règles d’accord, par exemple, sont consultables à l’intérieur des exercices. En effet, les notions du glossaire apparaissent dans une couleur spécifique, ce qui veut dire qu’elles sont cliquables et permettent donc d’être consultées pendant la réalisation des différents tests.

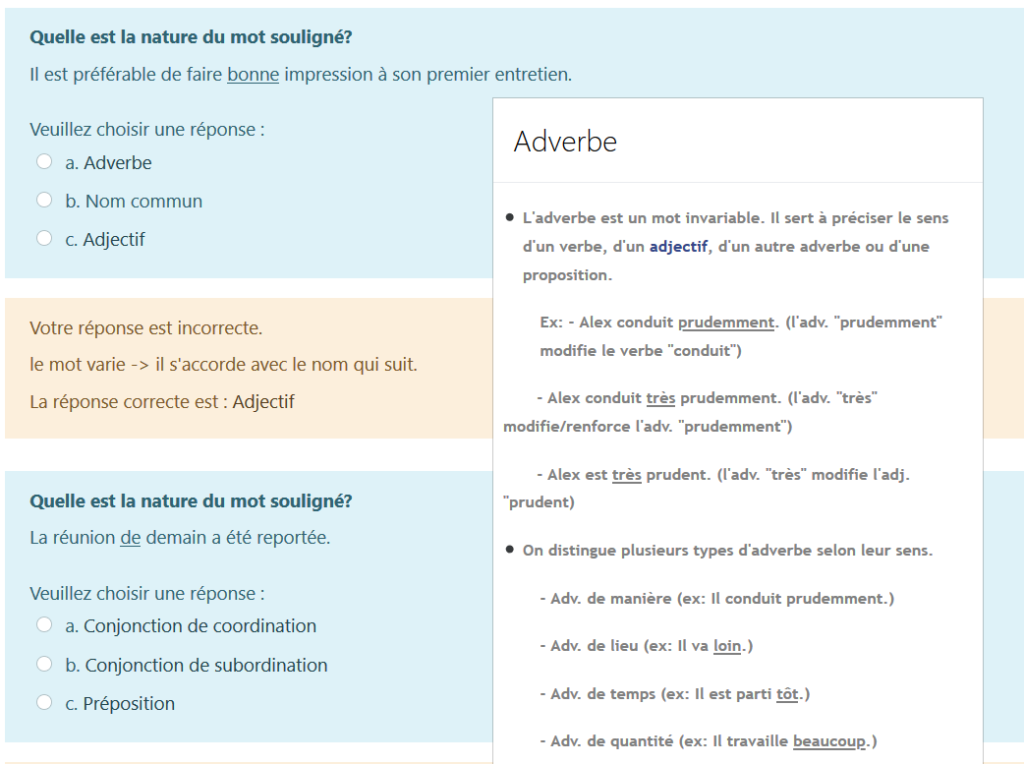

Dans l’exemple suivant, on voit que l’étudiant doit choisir entre 3 classes de mots. Or, il peut aller lire une explication en cliquant sur le mot. Dans l’illustration ci-dessous, les termes « Adverbe », « Nom commun » et « Adjectif » sont cliquables. Nous avons choisi de cliquer sur « Adverbe » pour montrer comment l’explication du glossaire apparait.

Image 1 : Illustration de l’affichage d’un article du glossaire

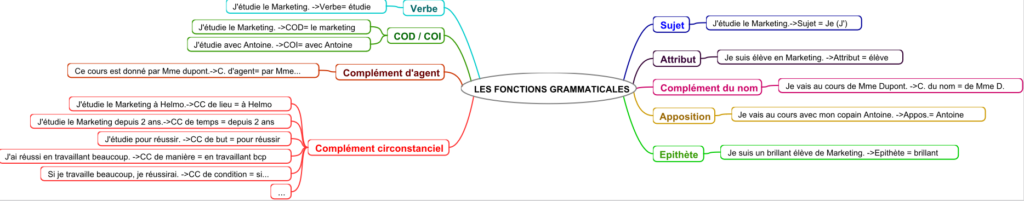

Un deuxième type de ressources présent dans le Parcours est le mind map. En effet, avant de réaliser certains tests, l’étudiant a la possibilité de consulter une carte conceptuelle de la matière. Il peut ainsi visualiser les informations, avoir une représentation différente, généralement plus synthétique de celles-ci.

Image 2 : Mind map des fonctions grammaticales

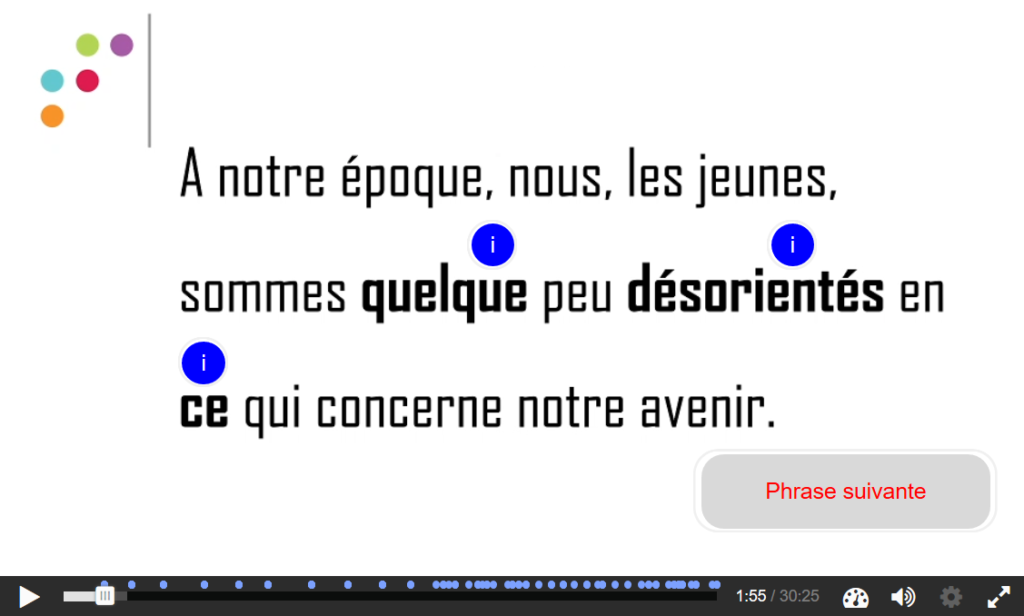

Un troisième type de ressources disponible est la dictée interactive, formative et ciblée. Avec l’aide du service e-learning, nous avons mis au point une dictée interactive grâce à l’outil H5P. Quelques mots sur le fonctionnement de ce dispositif. Tout d’abord, l’étudiant peut soit regarder la vidéo et écrire dans l’espace qui suit, soit ouvrir un lien pour rédiger avec les 2 fenêtres côte à côte. Dans ce cas, il peut visualiser à la fois la vidéo et le texte qu’il écrit au fur et à mesure. La vidéo débute avec quelques explications sur le fonctionnement de la dictée : le texte sera dicté phrase par phrase et après chaque phrase une correction apparait. Sur cette dia de correction se trouvent des mots en gras pour lesquels l’utilisateur peut obtenir une explication (un feedback détaillé) sur simple clic. Lorsque l’étudiant a corrigé sa production, il peut passer à la phrase suivante.

Image 3 : Exemple d’une phrase de la dictée interactive sur l’accord des participes passés

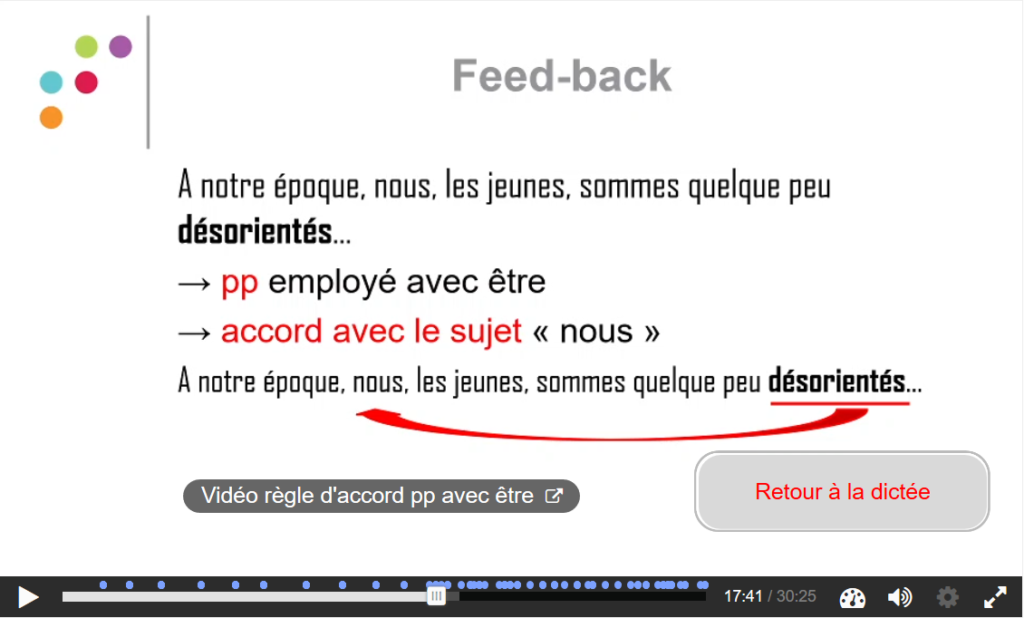

Voici un exemple de la correction que l’on obtient si on clique sur la bulle info. du mot « désorientés ».

Image 4 : Exemple d’un feedback de la dictée interactive sur l’accord des participes passés

L’étudiant voyage ainsi dans la vidéo et personnalise en quelque sorte sa correction, puisqu’il choisit d’aller consulter telle ou telle explication, en fonction de ses difficultés.

Actuellement, à notre connaissance, aucune dictée de ce type n’existe dans les outils en ligne permettant d’améliorer son orthographe.

Nous avions préalablement demandé à une classe de tester ce dispositif sur base volontaire. Une vingtaine d’étudiants s’étaient « prêtés au jeu » et avaient réalisé l’exercice. Parmi ceux-ci, 15 avaient répondu à un bref sondage sur le dispositif qu’ils trouvaient unanimement plus adapté que les anciennes dictées audios disponibles sur la plateforme. Tous s’accordaient sur l’adéquation du feedback. Ils avaient également la possibilité de faire un commentaire. Ils y relevaient surtout la pertinence des explications[2]. Les retours des collègues ayant consulté l’outil allaient dans le même sens.

Nous avons également réfléchi à la création d’une variante grâce à l’outil Streampad intégré dans Moodle. Cet outil permet de rédiger un texte de façon collaborative parallèlement au visionnage d’une vidéo. Il s’agirait alors d’une dictée négociée où les étudiants seraient amenés à argumenter, justifier et expliciter leurs choix orthographiques pour aboutir à un consensus. Cependant, sa mise en œuvre n’a pas encore été testée.

En plus d’être interactive, la dictée est formative, ce qui signifie qu’aucune note n’est attribuée à l’étudiant à la fin de l’exercice, car c’est bien d’un exercice dont il s’agit et pas d’un test. Son but est de permettre à l’étudiant de progresser. Il nous a semblé important de nous éloigner de la dictée traditionnelle, avec sa notation qui amène souvent à une dévalorisation et une démotivation. Dans cet exercice, ce n’est pas la faute qui est mise en évidence, mais le feedback.

Actuellement, seules deux dictées de ce type sont disponibles dans le Parcours, l’une cible l’accord des participes passés et l’autre les majuscules. D’autres dictées sont en cours d’élaboration. Idéalement, il faudrait que chaque utilisateur ait accès à une dictée pour s’entrainer lorsqu’il n’a pas validé son test.

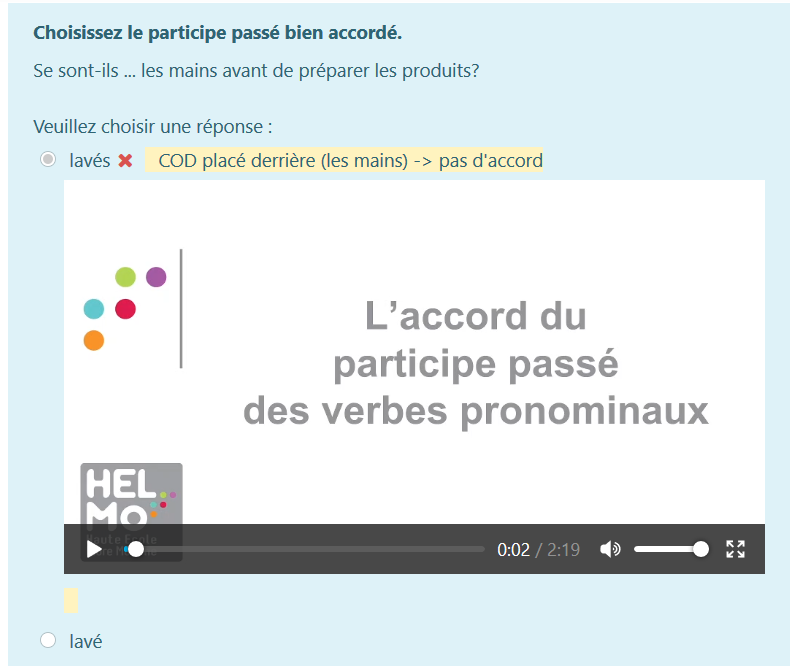

Le dernier type de ressource auquel l’utilisateur a accès est la vidéo. En effet, on retrouve de nombreuses vidéos dans les feedbacks des différents tests, car il nous a semblé primordial de fournir à l’utilisateur un feedback précis[3] et pas simplement un retour de type « juste ou faux ». Ainsi, l’étudiant reçoit en feedback une explication synthétique accompagnée parfois de la règle en vidéo, comme illustré ci-dessous.

Image 5 : Exemple d’un feedback vidéo

- Mise à l’essai

Etant donné qu’une expérimentation à petite échelle avec une poignée de candidats peut se révéler informative (Milanovic, 2002), nous avons demandé à un petit groupe de 15 étudiants de 1e Bac en Management Assistant de réaliser le Parcours lors du 1er quadrimestre de l’année académique 2020-2021. Ils ont commencé ledit Parcours la 3e semaine de cours, les 2 premières semaines étant consacrées à un module sur « Les représentations de l’orthographe » au cours duquel sont abordés l’importance et les enjeux de la maîtrise de l’orthographe. Ce module est censé conscientiser les étudiants et ainsi augmenter leur implication/motivation. A posteriori, le fait de ne pas ouvrir le parcours dès la 1e semaine de cours est apparu comme pertinent, car il permettait aux étudiants arrivés tardivement de commencer le Parcours en même temps que les autres. En plus de tester l’outil, nous avons également demandé aux utilisateurs de nous rapporter tout « problème » rencontré (validation des items). Voici ce qu’il ressort de cette première « mini » mise à l’essai. Tout d’abord, nous avons pu corriger des coquilles qui restaient dans certains items ainsi que des feedbacks qui étaient incorrects[4]. Deuxièmement, il ressort que les questions glisser-déposer sur texte ne fonctionnaient pas lorsqu’un même mot devait être utilisé plusieurs fois. Ce problème technique a été résolu. Ensuite, il s’avère nécessaire d’élargir la banque de questions, car les étudiants, dans certaines compétences en tout cas, se retrouvent face aux mêmes questions. La banque est constituée de plus ou moins 400 questions et doit passer à minimum 600 pour disposer d’une variété suffisante. Enfin, étant donné que quelques étudiants avaient oublié d’effectuer leur test hebdomadaire dans les temps, nous obligeant à leur octroyer une dérogation pour pouvoir y accéder, nous souhaitons mettre en place un rappel automatique. Ainsi, l’étudiant qui n’aurait pas encore terminé son test hebdomadaire recevrait un jour avant sa fermeture un mail de rappel. Pour ce faire, nous devrions installer un plug-in dans Moodle.

Expérimentation

Échantillon

Le dispositif a été testé dans différents groupes de 1er bacheliers Assistant de direction (Liège et Verviers), Droit, Coopération internationale et Instituteur préscolaire. Mis à part les instituteurs préscolaires, qui ont utilisé le parcours différemment des autres bacs de l’économique en raison d’un fonctionnement autre (notamment des stages au Q1), l’échantillon est constitué de 260 étudiants.

Méthodologie

Malheureusement, nous n’avons pu appliquer la méthodologie choisie au départ, à savoir des groupes tests/expérimentaux et des groupes témoins. En effet, nous ne pouvions imposer un outil à certains groupes d’une même formation et pas à d’autres, car cela aurait pu être considéré comme discriminant. De plus, la fiche UE ne nous permettait pas d’appliquer deux traitements distincts.

C’est pourquoi nous avons proposé le dispositif à l’ensemble des groupes, avec un point bonus à l’examen pour les étudiants qui auraient réalisé l’entièreté du Parcours.

Un prétest (25 questions balayant les 5 compétences travaillées dans le Parcours guidé) a été réalisé fin septembre, avant l’ouverture du Parcours guidé et un post-test a été réalisé en décembre, juste après la fermeture du Parcours. Le post-test, qui a donc eu lieu à environ 3 mois du prétest, comportait les mêmes questions que celui-ci, mais dans un ordre différent. Ces deux tests ont été effectués en ligne lors du cours de bureautique. Cependant, pour des raisons organisationnelles, tous les groupes n’ont pu effectuer le post-test à ce cours et ont donc dû le faire de chez eux. Par ailleurs, de nombreux étudiants étaient absents au dernier cours de bureautique. Nous avons donc eu un nombre réduit de post-tests comparativement aux prétests.

Heureusement, au bachelier en droit, une dictée a également été réalisée en pré et post-test. Etant donné la difficulté de trouver ou d’élaborer une dictée comportant le même nombre de mots ainsi que les mêmes difficultés, nous avons opté pour le même texte en pré et post-test. Cette dictée a constitué un élément de comparaison supplémentaire.

Nous avons également utilisé les résultats à l’examen de français comme indicateur.

[1] Pourcentage d’étudiants ayant réussi la question. Cet indice indique à quel point une question est réussie ou échouée et permet donc de repérer les questions qui posent problème, soit à cause de la question elle-même (défaut dans la question, dans la formulation de l’énoncé), soit parce que la matière n’est pas acquise chez les étudiants. Si trop de questions sont trop faciles, le test ne mesure peut-être pas ce qu’il devrait mesurer.

[2] Corrélation entre le résultat à cette question et le total du test. Lorsqu’une question est bien faite, les étudiants qui réussissent bien à cette question sont les mêmes qui réussissent bien dans le total du test. Si les étudiants faibles réussissent mieux que les élèves forts à une question en particulier, il y a peut-être un problème avec la question.

[1] Trop souvent délaissée dans les apprentissages (Dufour, 2014) alors que d’un point de vue didactique, elle est d’une importance capitale dans le développement des compétences langagières, car elle fournit une aide précieuse à la lecture et à l’écriture (Catach, 1996).

[2] « C’est parfait et ça permet de nous entraîner ainsi que de comprendre nos fautes. » / « C’est vraiment mieux que les anciennes dictées! C’est facile à utiliser et avec les boutons d’action c’est vraiment bien fait! » / « Très bonne idée de dictée, la correction est une bonne chose et cela m’a permis de bien comprendre mes fautes. » / Facile d’utilisation, vitesse et enchaînement adapté. Très intéressant d’avoir directement la correction phrase par phrase mais aussi les explications de mots plus complexes. »

[3] Comme le soulignent les neurosciences, « le retour rapide et continu d’informations (feedback) sur ses performances est essentiel à toute bonne pédagogie ou remédiation (Houdé, 2018).

[4] Lors de la création des questions, nous utilisons fréquemment la fonction « dupliquer » pour un gain de temps évident. La consigne reste la même, seule la phrase change. Il peut donc arriver qu’on duplique la question et qu’on oublie de modifier le feedback.